« 動物体験デバイス | メイン | マイクロソフトSource Fourceフィギュア »

2008年02月18日

リアルタイム顔認識

スタンフォード大で開催されたメタバースサミット(そんなのやってたのか)で、リアルタイム顔認識技術のseeingmachinesという会社のデモをRobert Scobleが絶賛しているので見てみた。

ノートPC(Mac)のカメラとソフトウェアで、目や口の位置をリアルタイムに追跡して、顔の位置を追っていSeeing Machinesという会社のデモ。

アイトラッキング用の技術は普及しているようだが、まばたきや口の動き、画面を向いているか注意がそれているか、画面はつけているけど別のところ(テレビとか)を見ているとかもリアルタイムで取れるということだ。ウェブサイト上に起こった動きに対して起こる反応や、目と口の位置の変化から感情も取れたりするのかも。

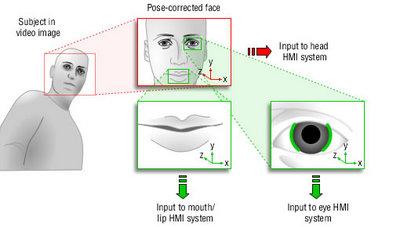

メタバース(セカンドライフに代表される仮想世界)のカンファレンスに来ているということは、カメラで撮った自分の動きを3D内のキャラクターに再現させるような用途も考えているのだろう。サイトにはこういうデモ画像もあった。

ライブラリとしてライセンスもされているということだ。これを使えば、Ustreamで自動的に目線を入れるとか、ヒゲチェンのリアルタイム版とかも作れるのかも。

送った写真を動かすようなものはあるけど、動いているものにそのまま対応するようなサービスってもうあったっけ?

投稿者 秋元 : 2008年02月18日 09:32

トラックバック

このエントリーのトラックバックURL:

http://labs.cybozu.co.jp/cgi-bin/mt-admin/mt-tbp.cgi/1774

コメント

Intel の OpenCV は ffpmeg にも対応しているので、これと同じことは出来そうです。ソニーのウェブカム付きノートPCでも同じようなものを現在店頭デモで行っていますね。あえて絶賛しているということはパフォーマンス面などで素晴らしいものがあるとか、こちらで書かれているように ustream などウェブで使いやすいタイプのライブラリになっているとかのアドバンテージがあるんじゃないでしょうか?

投稿者 Ryuji Kanbe : 2008年02月19日 11:29